“天下武功,唯快不破”,你需要以“快”制胜。

如今,全(quán)球(qiú)顶级(jí)公司的研究人员和数据科学家(jiā)团队们都(dōu)在致力于创建更为复杂的AI模型(xíng)。但是,AI模型的创建(jiàn)工作不仅仅是(shì)设计模型,还需要对模型进(jìn)行快速地训练。

这就是为什么说,如果想在AI领域保持领导力(lì),就(jiù)首先需要(yào)有赖于AI基础设施(shī)的领导力。而这(zhè)也正(zhèng)解释了为什么MLPerf AI训练结(jié)果如此之重要。

通(tōng)过(guò)完成(chéng)全部(bù)6项MLPerf基准测试,NVIDIA展现出了全球一(yī)流的性能表(biǎo)现(xiàn)和(hé)多功能性。NVIDIA AI平台在训练性能方面(miàn)创下(xià)了八项(xiàng)记录,其中包(bāo)括三(sān)项(xiàng)大规模(mó)整体性能纪录和五项基(jī)于每个加速器的性能纪录。

表1:NVIDIA MLPerf AI纪录

每个加(jiā)速器的比(bǐ)较基于早前报告(gào)的基于单一NVIDIA DGX-2H(16个 V100 GPU)、与其他同规模相比较的MLPerf 0.6的性(xìng)能(除MiniGo采用(yòng)的(de)是基(jī)于8个V100 GPU的NVIDIA DGX-1 ) |最大规模MLPerf ID:Mask R-CNN:0.6-23,GNMT:0.6-26,MiniGo:0.6-11 |每加(jiā)速(sù)器MLPerf ID:Mask R-CNN,SSD,GNMT,Transformer:全(quán)部使用0.6-20,MiniGo:0.6-10

以上测试结果数据(jù)由谷歌、英特尔、百度、NVIDIA、以及创建MLPerf AI基准测试的其他数十(shí)家顶级技(jì)术公司和大学(xué)提供背书,能够转化为具有重要意(yì)义的创新。

简(jiǎn)而言之,NVIDIA的AI平台如今(jīn)能够在不到两分钟的时间内(nèi)完成此(cǐ)前需要(yào)一个工作日才(cái)能完成的模型(xíng)训练。

各公(gōng)司都知道,释放生产力是一件(jiàn)重中之重的要务。超级计算机如今已经(jīng)成为了AI的必备工具,树立AI领域的领导力首先需要强大的AI计(jì)算基础设施支(zhī)持。

NVIDIA最新的MLPerf结果很好地展示了将NVIDIA V100 Tensor核心GPU应用于超(chāo)算级基础设施中所(suǒ)能带(dài)来的益处。

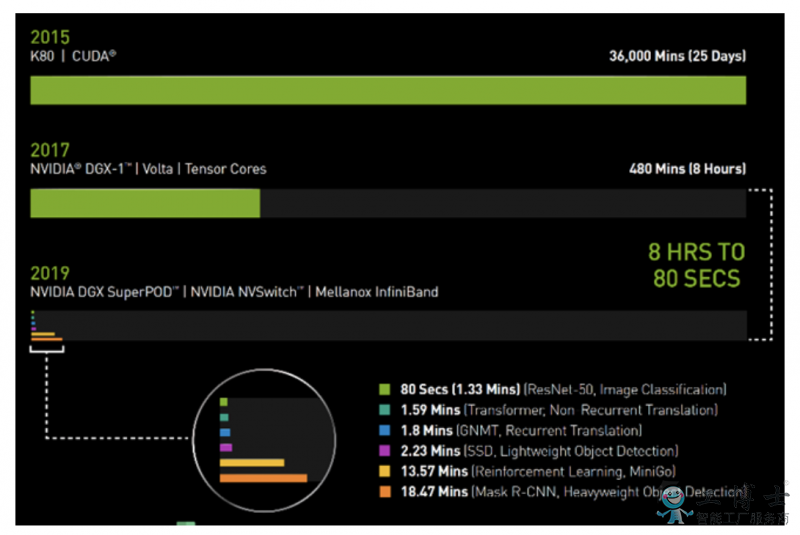

在2017年春季的时候,使用搭载了V100 GPU的NVIDIA DGX-1系(xì)统训练图像(xiàng)识别模型ResNet-50,需要花费整整一个工作日(8小时)的时间。

而如今,同样的任务,NVIDIA DGX SuperPOD使用相(xiàng)同的V100 GPU,采(cǎi)用Mellanox InfiniBand进行互联,并借助可用(yòng)于分布式AI训练的最(zuì)新NVIDIA优(yōu)化型AI软(ruǎn)件,仅需80秒即可完成。

80秒的时间,甚至都不够用来(lái)冲一杯咖啡。

图1:AI时(shí)间机器

2019年MLPerf ID(按图表从上到下(xià)的顺序):ResNet-50:0.6-30 | Transformer:0.6-28 | GNMT:0.6-14 | SSD:0.6-27 | MiniGo:0.6-11 | Mask R-CNN:0

AI的必备工具:DGX SuperPOD 能够(gòu)更快(kuài)速地(dì)完成工作负(fù)载

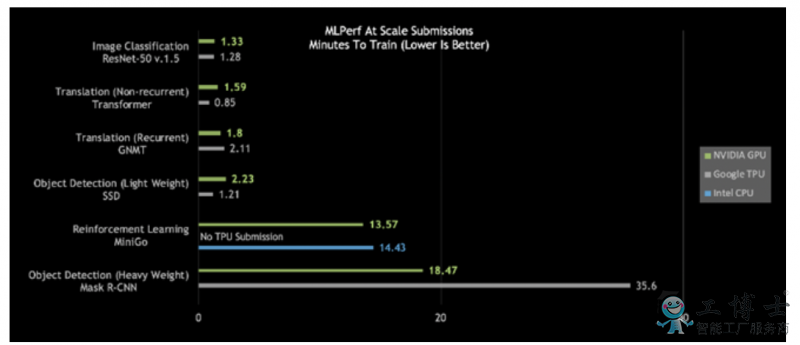

仔细观察今日的MLPerf结果,会发(fā)现NVIDIA DGX SuperPOD是唯一在所有六个MLPerf类别中耗时都少(shǎo)于20分钟的AI平台:

图2:DGX SuperPOD打破大规(guī)模AI纪录

大规模(mó)MLPerf 0.6性能 | 大规模MLPerf ID:RN50 v1.5:0.6-30,0.6-6 | Transformer:0.6-28,0.6-6 | GNMT:0.6-26,0.6-5 | SSD:0.6-27,0.6-6 | MiniGo:0.6-11,0.6-7 | Mask R-CNN:0.6-23,0.6-3

更进(jìn)一步(bù)观(guān)察会发(fā)现,针对重量级目标检测和强化学(xué)习(xí),这些最困(kùn)难的AI问题,NVIDIA AI平台在总体训练(liàn)时间方面脱颖(yǐng)而出。

使(shǐ)用(yòng)Mask R-CNN深度神经网络(luò)的重量级(jí)目(mù)标检测可为用户提供高级实例分割(gē)。其用途包括将(jiāng)其与多个数(shù)据源(yuán)(摄像头、传感器、激光雷达、超(chāo)声波等)相结合(hé),以精确(què)识别并定位特(tè)定目标。

这类AI工作负载有(yǒu)助于(yú)训练自动驾驶汽车,为其提供(gòng)行人和其(qí)他目标的精确位置。另外,在医疗健康领域,它能够帮助医生在医(yī)疗扫描中查找并识别肿瘤。其意义的重要性非同小可。

NVIDIA的“重(chóng)量级目标检测”用时不到19分(fèn)钟,性能几乎是第二名的两倍。

强化学习是另一有难度的类别。这种AI方(fāng)法能够用于训练工厂(chǎng)车间(jiān)机(jī)器(qì)人,以简化生产。城市也可以(yǐ)用这种方式来控(kòng)制交通灯,以减少拥堵。NVIDIA采用NVIDIA DGX SuperPOD,在(zài)创纪录的13.57分钟内完成(chéng)了对MiniGo AI强化训练模型的训练。

咖啡还没(méi)好,任务已完成:即时AI基(jī)础设施提供全球领先性(xìng)能

打破基准测(cè)试纪(jì)录不是目的,加速创新才是目(mù)标。这就是为什么NVIDIA构建的DGX SuperPOD不仅性能强(qiáng)大(dà),而且易于(yú)部署(shǔ)。

DGX SuperPOD全面配(pèi)置了可通过NGC容(róng)器注册表(biǎo)免费获取的优化型(xíng)CUDA-X AI软件,可提供开箱即用(yòng)的全球(qiú)领先AI性(xìng)能。

在这个由130多(duō)万名CUDA开发者组成的(de)生态系统中,NVIDIA与(yǔ)开发者们合(hé)作,致力于为所有AI框(kuàng)架(jià)和开发环境提供有力支持。

我们已经助力(lì)优化了数百万(wàn)行代码(mǎ),让我(wǒ)们的客户能够将其AI项目落地,无论(lùn)您(nín)身在何处都可以(yǐ)找到(dào)NVIDIA GPU,无论是在云端,还是在数(shù)据中心,亦(yì)或(huò)是(shì)边缘(yuán)。

AI基础设施如(rú)今有够快,未来会更快

更好的(de)一(yī)点(diǎn)在于,这一(yī)平台的(de)速度一直(zhí)在(zài)提升。NVIDIA每月都会(huì)发布CUDA-X AI软件的新优化和性能(néng)改进,集成(chéng)型软件堆(duī)栈可在NGC容器注(zhù)册表中免费(fèi)下载,包(bāo)括容器化的框(kuàng)架、预先训(xùn)练好的模型(xíng)和脚(jiǎo)本。

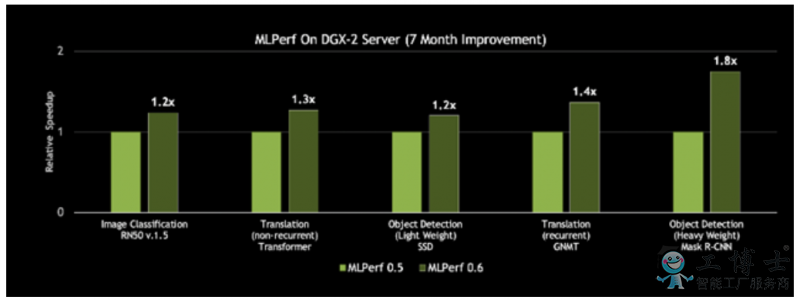

借助在CUDA-X AI软件堆栈上的创新,NVIDIA DGX-2H服务器的MLPerf 0.6吞吐量比NVIDIA七个月前发布的结果提升了80%。

图(tú)3:基于同一服务器,性能提升高达80%

对单个历元上单一(yī)DGX-2H服务器的(de)吞吐量(liàng)进(jìn)行比较(jiào)(数据集单次通过神经网络)| MLPerf ID 0.5 / 0.6比较:ResNet-50 v1.5: 0.5-20/0.6-30 | Transformer: 0.5-21/0.6-20 | SSD: 0.5-21/0.6-20 | GNMT: 0.5-19/0.6-20 | Mask R-CNN: 0.5-21/0.6-20